本章将探讨深度学习、生成式人工智能与大模型的概念、原理、应用以及未来发展趋势。深度学习是一个多层堆叠的学习框架,在感知问题上取得了巨大成功。生成式人工智能专注于预测目标的概率分布。大模型具有大量参数,在大数据上进行训练,能够生成出逻辑性和创造性的文本、 图像、音乐等内容,但需要大量计算资源和较长训练时间。深度学习与生成式人工智能是大模型的两个核心技术,共同推动着大模型的快速发展与广泛应用。

3.1 深度学习

深度学习在2010年左右崭露头角,很快成为机器学习领域的一场革命。2011年,IDSIA 的Ciresan开始利用GPU训练的深度神经网络赢得了学术图像分类竞赛,这是现代深度学习的第一次实际成功。2012年, 由Hinton所指导的Krizhevsky团队参加了当时难度很大的大规模图像分类挑战赛ImageNet,需要对140万张图像进行训练并将高分辨率彩色图像分类为1000个类别。该团队实现了83.6%的前五名准确率,这是一项重大突破。在2011年,基于经典计算机视觉方法的获胜模型的前五名准确率仅为74.3%。此后,每年的竞赛几乎都由深度卷积神经网络主导,到2015年,获胜者的准确率已经达到96.4%,因此ImageNet被认为是一个完全解决的问题。

自2012年以来,深度卷积神经网络已经成为所有计算机视觉任务的首选算法,甚至更广泛地处理各种感知任务。在主要的计算机视觉会议上,几乎所有的研究都涉及某种形式的卷积网络。与此同时,深度学习也在许多其他类型的问题上得到了应用,例如自然语言处理。它已经完全取代支持向量机和决策树等传统方法。例如,多年来,欧洲核子研究组织CERN一直使用基于决策树的方法来分析大型强子对撞机 ATLAS 探测器的粒子数据,之后转而使用基于 Keras 的深度神经网络,因为它们具有更高的性能并且易于在大型数据集上进行训练。

深度学习是一种基于多层人工神经网络结构的机器学习方法,通过多层次的特征提取和抽象,实现对数据的高效表示和学习。深度学习模型由前绩神经网络、循环神经网络和卷积神经网络等叠加而成。叠加的层数称为深度,通常包括数十甚至数百个连续的表示层。每层执行的操作由其权重决定。模型的学习目标是找到使网络能够正确映射数据输入到目标输出的权重值。

深度神经网络包含大量参数,调整其中一个可能影响其他参数行为。为了优化网络表现,需要使用损失函数衡量预测输出与真实目标之间的差距,并通过反向传播算法调整权重值以降低损失函数。随机初始化网络参数。在训练过程中,优化器根据损失函数的反绩信号微调参数,使损失函数值逐渐降低,直至网络收敛到最小化损失的状态,此时网络的输出尽可能接近预期目标,称为训练好的网络。

深度学习不等于依次使用浅层学习。深度学习的变革之处在于其允许模型同时联合学习所有表示层,而不是依次学习。通过联合特征学习,每当模型调整其中一个特征时,其他特征会自动适应变化,不需要人工干预。深度学习通过逐层学习复杂的抽象表示,并将其分解为一系列简单的转换来实现这一点。这种逐层的联合学习方式使得深度学习比依次使用浅层学习模型更加成功, 因为多层模型中的最佳第一层并不是单层或两层模型中的最佳第一层。

深度学习在感知领域取得了巨大成就,包括:图像分类接近人类水平,能够准确识别图像中的对象和场景;语音识别接近人类水平,将语音准确转换为文本;手写转录接近人类水平,能够准确将手写文本转录为数字或文字;改进的机器翻译,使得机器翻译逼近人类水平;改进的文本到语音转换,使得生成的语音更加流畅自然;数字助理(如Google Now和Amazon Alexa)使得语音交互更智能和人性化,能够准确理解用户指令并提供相应服务。

3.2 生成式人工智能

生成式人工智能(Generative Artificial Intelligence,GenAI)指具有生成能力的人工智能系统,能够根据输入数据生成新的内容或样本。它们不仅分析、预测或分类已有数据,还能生成新的数据、文本、 图像、音频等内容。生成式模型起源于20世纪50年代的隐马尔可夫模型和高斯混合模型,并随着深度学习的发展,在语音识别和图像恢复等领域取得了显著性能改进。GenAI 借鉴了人类创造力和想象力,推动了人工智能的发展。

深度生成模型是一类具有多层结构的生成式模型,包括深度生成对抗网络(Deep Convolutional Generative Adversarial Network,DCGAN)、深度Boltzmann机(Deep Boltzmann Machines)等。这些模型通过堆叠多个隐藏层来学习数据的分布,并生成新的数据样本,在捕捉数据复杂分布和生成高质量样本方面表现出色。而变分自编码器、生成式对抗网络等 GenAI 模型为其提供了重要的理论基础和方法支持。

变分自编码器(Variational Autoencoders,VAEs)是一种生成式模型,结合了自编码器的结构和变分推断。它通过学习数据的潜在表示来实现数据的生成和重建。与传统的自编码器不同,VAEs不仅学习如何将输入数据编码为潜在空间中的分布,而且学习如何从该分布中采样生成新的数据点。这使得VAEs能够生成具有多样性的新数据,同时保持数据的连续性和可解释性。VAEs已被广泛应用于图像生成、语音合成、自然语言处理等领域,在生成式建模和数据生成任务中发挥着重要作用。

生成式对抗网络(Generative Adversarial Networks,GANs)是一种由两个神经网络组成的框架,旨在实现数据的生成。GANs由生成器和判别器两部分组成,它们相互对抗地学习,以提高生成器生成逼真数据的能力。生成器试图生成与真实数据相似的样本,而判别器则尝试区分生成器生成的假样本和真实数据。通过这种对抗学习的方式,生成器不断提升生成样本的逼真程度,而判别器也不断提升对真假样本的鉴别能力。GANs已被广泛用于图像生成、风格转换、超分辨率重建等任务,并在计算机视觉和图像处理领域取得了显著的成就。

去噪扩散概率模型(Denoising Diffusion Probabilistic Models,DDPM)是一种生成式模型,旨在对数据的概率分布进行建模,并通过去除数据中的噪声来提高模型的质量。该模型利用了扩散过程的概念,通过在训练过程中逐步将数据与噪声混合,然后试图从混合后的数据中恢复原始数据,从而学习数据的概率分布。通过这种方式,DDPM能够产生高质量、逼真的样本,适用于图像生成和其他生成式任务。

上述模型被认为是GenAI里程碑式的进步,实现方式和应用场景有所不同,涉及概率论、统计学、信息论和机器学习等多个理论和方法。模型训练常采用高效的对比学习方法(Contrastive Learning)。这是一种无监督学习方法,用于学习数据的表示。它通过最大化相似样本之间的相似性,最小化不相似样本之间的距离,从而学习到数据的有用表示。对比学习在图像、文本等领域的生成任务中取得了显著的成果。

GenAI模型通常会假设数据服从某种概率分布,如均匀分布、高斯分布、高斯混合分布等。生成模型学习数据的概率分布, 以便生成新的数据样本。Bayes定理用于计算在观察到数据后参数的后验分布,在GenAI中被用于估计模型参数。变分推断用于近似推断概率模型后验分布的方法,它通过最大化变分下界来逼近真实后验分布,被用于训练 VAEs 等模型。

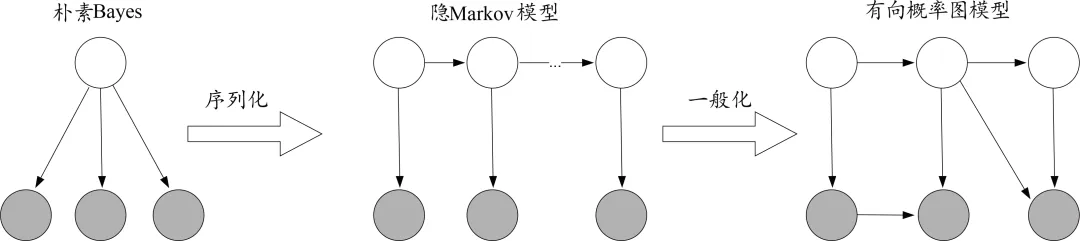

GenAI模型通常用概率图模型(Probabilistic Graphical Models, PGMs)建模不确定性,使得推理变得更加灵活和高效。PGMs 是一种用图形表示变量之间概率关系的方法,结合了概率论和图论的原理,旨在描述复杂系统中的随机变量之间的依赖关系(图3)。PGMs通常分为两类:Bayes网络,使用有向图表示变量之间的因果关系;Markov网络,使用无向图表示变量之间的相关关系。被广泛应用于机器学习、人工智能、计算机视觉等领域,用于推断、预测和决策问题。

图3 典型概率图模型。包括:朴素Bayes、隐Markov模型、有向概率图模型等。

GenAI 模型通常用潜变量模型(Latent Variable Models,LVMs)揭示观测数据背后的潜在结构,提高对数据的理解和分析能力。LVMs 假设存在一些不能直接观测到的潜在变量,它们以某种方式影响了观测到的数据。例如,Hidden Markov Models (HMMs) 引入潜变量对观测序列进行建模,假设观测序列的生成过程由一个不可见的隐藏状态序列所控制,该隐藏状态序列是一个 Markov 链,每个隐藏状态生成一个相应的观测值,构成观测序列。LVMs 还包括非学习方法,如因子分析、潜在语义分析、潜在 Dirichlet 分配 citeBlei2003 等,在数据降维、话题建模等领域都有应用。

交叉嫡是用于度量两个概率分布之间的相似性的指标。在 GenAI 中,交叉嫡常用于衡量生成模型生成样本与真实数据之间的差异,以及用于模型训练中的损失函数。信息嫡是用于度量随机变量不确定性的指标。在 GenAI 中,信息嫡可以用来衡量数据的不确定性, 以及用于模型中的正则化项。

自注意力机制用于捕捉序列中不同位置之间的长程依赖关系,最早用于 Transformer 中。该 GenAI 模型主要用于自然语言处理任务,例如机器翻译和文本生成。Transformer 由多层自注意力机制和前绩神经网络组成,具有并行计算的优势,能够处理长距离依赖性和捕获输入序列中的重要信息。编码器和解码器是 Transformer 的核心组件,每个组件都由多个相同结构的层堆叠而成。在每个层中,Transformer 使用自注意力机制来计算序列中每个位置的表示与其他位置的关系,以更好地捕获上下文信息。

3.3 内容生成式大模型

内容生成式人工智能(Artificial Intelligence Generated Content,AIGC)是GenAI在特定领域或任务中的应用,专注于生成文本、 图像或音频等内容。它根据领域数据的特点和需求采用不同的模型结构和训练方法,以实现出色的生成效果。AIGC与深度学习相结合,构建参数规模巨大的大模型,并在规模相当的大数据上进行训练,涌现出了AIGC大模型,在语言生成、 图像生成、音乐创作等领域展现出了惊人的创造力和表现力。可以利用这些模型为创作者提供灵感。以下介绍4个广受关注的 AIGC大模型。

GPT系列(Generative Pre-trained Transformer)由OpenAI提出,其最新版本是 GPT-41(1 https://openai.com/gpt-4)。该系列模型采用自回归式生成方法,能够根据前文生成后续文本,并且在训练时通过大规模的文本数据进行预训练,从而学习到了丰富的语言知识和语义信息。GPT系列模型在文本生成、对话系统、语言理解等任务中取得了显著的成绩,被广泛应用于智能客服、智能写作、智能编程等领域。

Stable Diffusion模型是一种基于扩散技术的AIGC大模型,于2022年由 StabilityAI、CompVis 与 Runway 合作开发2(2 https://stability.ai/news/stable-difusion-public-release)。它主要用于根据文本的描述产生详细图像、补画、扩画,以及在提示词指导下的图像到图像转换,即将源图像转换为目标图像,同时保留原始图像的一些视觉属性。该模型通过对输入噪声进行多次选代扩散,逐渐生成出高质量的图像, 由3个部分组成:VAE、U-Net和一个文本编码器。

DALL-E系列是由 OpenAI 提出的AIGC大模型,用于图像生成任务3(3 https://openai.com/dall-e-2)。与传统的图像生成模型不同,该模型能够根据用户输入的文本描述生成与描述相符的图像。例如,用户可以输入“牛顿与爱因斯坦交谈的场景”,DALL-E就能够生成出符合描述的图像。这种基于文本的图像生成技术为图像创作、设计等领域带来了全新的可能性。

GLM(General Language Model)是由清华大学自然语言处理与社会人文计算实验室开发的通用预训练模型4(4 https://keg.cs.tsinghua.edu.cn/glm-130b/)。GLM采用了类似于OpenAI 的GPT(Generative Pre-trained Transformer)模型的结构,在大规模文本数据上进行了预训练,旨在为中文自然语言处理任务提供一个高效、准确的基础模型。

3.4 生成式人工智能的特点、优势与局限

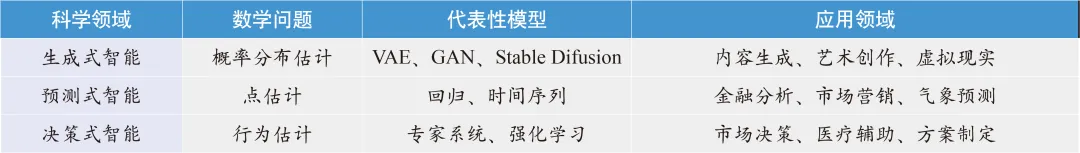

生成式智能通过学习数据的潜在分布和模式来创造新的内容,如图像、音乐、文本等。生成式智能的核心是利用生成模型,如GAN和VAE,来学习数据的分布,从而生成具有相似特征的新数据。与之不同的是预测式智能,其根据历史数据来预测未来事件或趋势的人工智能技术。它通过分析数据之间的关系和模式,利用统计算法和机器学习模型来进行预测。预测式智能的核心是建立预测模型,如回归模型、时间序列模型和分类器,用于对未来事件进行预测(表1)。

表1 生成式、预测式、决策式智能的特点

生成式智能主要用于创造性领域,如艺术创作、 内容生成和虚拟现实等。它可以生成逼真的图像、音乐和文本,具有广泛的应用前景,如图像生成、音乐合成、文本生成等。预测式智能广泛应用于商业和科学领域,如金融、医疗、市场营销和气象预测等。它可以用于股票价格预测、疾病预测、消费者行为分析等,帮助决策制定和规划未来,帮助人们做出更明智的决策。两者在技术原理和应用领域上有着不同的特点和优势。

GenAI具有多种优势,可以提高效率,节约成本。例如,它可以比人类更快地创建内容,帮助团队在更短的时间内完成更多的工作。无论是撰写文章、设计图形还是生成代码,生成式人工智能都可以更快地完成。它可以减少重复性任务,进而减少对人力资源的需求。生成式人工智能可以提高创造力,能够生成创意内容,如独特的艺术品或音乐。生成式人工智能可以在这些领域辅助甚至取代人类的创造力,成为艺术家和创作者的基本工具。

ChatGPT和Google Bard等AIGC在软件开发中发挥着重要作用。开发人员可以使用这些人工智能来简化他们的工作。开发者可以给出代码片段或者错误提示,AI为其提供解决方案。生成式人工智能还可以根据给出的指令或提示生成示例代码。AIGC控制聊天机器人和虚拟代理,使它们反应灵敏且高效。在客户服务中,聊天机器人现在处理大部分询问,减少了人工参与的需要。这些人工智能代理可以接受训练来回答问题、解决问题并快速提供信息。AIGC有助于创建各种形式的内容,例如音乐、视频、图像等。通过分析现有样本,它可以生成新的、真实的内容。这项创新通过简化内容创建流程,使媒体、设计和创意艺术等领域受益。它使艺术家和创作者能够快速创作新鲜且引人入胜的内容。

GenAI模型有其局限,需要仔细考虑道德和滥用问题。近年来,滥用GenAI模型来创建误导性和虚假内容的情况有所增加。该技术可用于创建与真实内容几乎相同的虚假图像、视频和音频内容。例如,可以使用生成式人工智能创建虚假新闻文章、误导性视频和操纵图像,从而导致媒体的混乱和不信任。这会对隐私、声誉和信息传播产生严重影响。生成式人工智能创造此类欺骗性内容的潜力带来了巨大挑战,需要解决这一挑战, 维护数字世界的信任和完整性。

GenAI模型对其训练数据强烈依赖。这些模型不具有独立的推理或判断,因此它们完全依赖于训练的数据。如果训练数据有限、有偏见或不准确,可能会导致生成式人工智能生成质量较差的内容。为了缓解这种情况,提供多样化且充足的训练数据以确保生成的内容尽可能公正和准确至关重要。Open AI的Kaplan等人发现了 Transformer等GenAI大模型在交叉嫡损失上存在尺度定律(Scaling Law)。损失随着模型大小、数据集大小以及用于训练的计算量呈幕律变化,一些趋势的尺度超过了107。而宽度或深度等其他架构细节方面,在很大范围内对损失的影响较小。

Kaplan等人通过方程描述了过拟合对模型与数据集大小的依赖性,以及训练速度对模型大小的依赖性。这些关系能够确定计算预算的最佳分配。较大的模型在样本利用效率上显著更高, 因此最优的计算高效训练涉及在相对较小的数据上训练非常大的模型,并在收敛之前明显停止。尺度定律被用于指导模型训练和优化,合理分配资源,选择合适的训练策略,被认为是大模型时代的Moore定律。