“神经网络学到的是生成文本的过程中的某种表示,这些模型的生成文本实际上是真实世界的投影……(语言模型)对下一个单词的预测越准确,(对于世界知识)保真度就越高,在这

个过程中获得的分辨度就越高……”

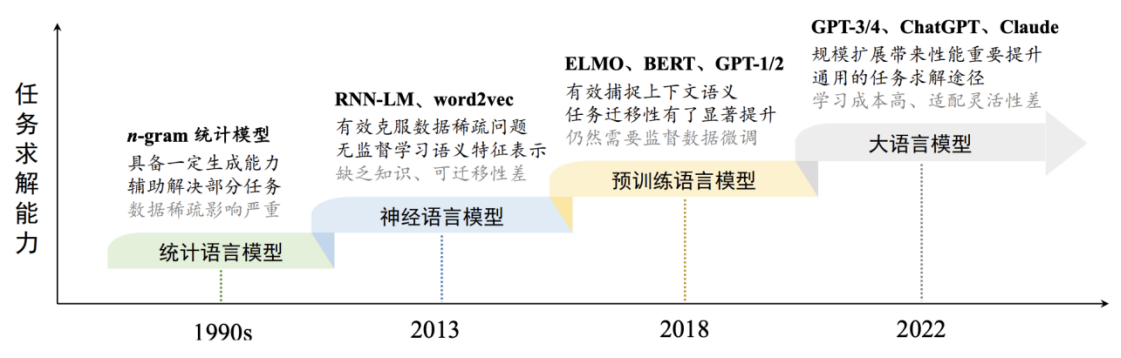

大语言模型发展史

LLM的发展历程最早可以追溯到 20 世纪中期,共分为HMM、N-gram、RNN、Transformer和GPT五个阶段,而Transformer是一个重要的分水岭。

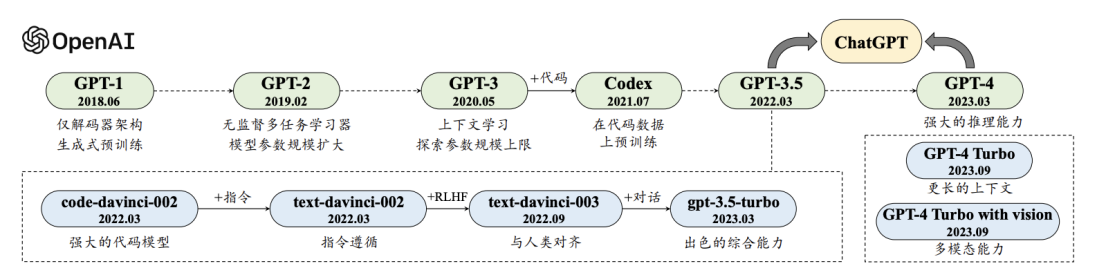

大模型与GPT时间线对比

大模型

GPT

第一阶段,HMM

隐马尔可夫模型(HMM)于 20 世纪中期首次出现,并在 20 世纪 70 年代开始流行,该模型对句子的语法结构进行编码,用于预测新单词。HMM 在预测新内容时,只会考虑最后的输入。比如:输入“I went to the store and ”,需要预测生成新内容,但由于 HMM 只会看到最后一个标记“and”,信息如此少,不太可能给到我们满意的预测。

第二阶段,N-gram

20 世纪 90 年代,N-gram 模型开始流行起来,与 HMM 不同,N-gram 能够接受一些标记作为输入。比如,对于前面的例子,N-gram 能根据 “the store and” 来预测后面的内容,所以会表现得比较好。但由于接收的输入标记数量还是很有限,所以预测效果还是不理想。

第三阶段,RNN

2000 年左右,循环神经网络变得特别流行,因为它们能够接受更多数量的输入标记。特别是,LSTM 和 GRU(RNN 的类型)得到了广泛的应用,并且可以产生相当好的结果。然而,RNN 在处理很长的文本序列时存在不稳定问题。

第四阶段, Transformer

2017 年,Google 发布了 Transformer 模型,Transformer 允许输入标记数量大幅增加,消除了 RNN 的不稳定问题。

同时,利用注意力机制,模型学会对输入的不同部分分配不同的注意力,更关注那些对当前任务更重要的信息,能够更好地捕捉上下文关系,输出更合理的内容。以上面例子举例,输入“I went to the store and ”,模型预测生成了“bought”,在这种情况下,模型除了需要预测 “buy” 这个动词外,还需要根据上下文中的“went”推断出过去式。

第五阶段, GPT

GPT 是基于 Transformer的一种特定模型,通过在大规模语料库上进行无监督的预训练,然后在特定任务上进行微调,可以适应各类任务场景,尤其在文本生成、对话系统、问题回答等生成式任务上表现出色。

大语言模型使用场景

GPT 经过了大量语料的预训练和特定任务的微调,在各行各业都能“有所作为”,与其问它能做什么,不如问想让它做什么。这里我们列举了一些典型的应用场景,带大家初步领略下大语言模型的潜力和魅力。

智能客服。利用大语言模型强大的语义理解能力,加上检索增强生成(RAG)技术,可以很方便地训练出基于本地知识库的智能客服。可能以后淘宝小二一声声“亲”的背后,不再是抠脚大汉,而是人工智能了。

智能教育。AI+ 教育,也是 AI 应用的一个大方向。想象一下,以后不用大成本,就能“请”到一个非常专业、非常全面的家庭教师,能根据学生的学习情况实时调整学习计划,提供个性化的教育辅导,帮助学生更好地理解和掌握知识,实现真正的教育平等。

编程辅助。说到我们最熟悉的编程领域,在提效方面,只要用过 ChatGPT 的同学,肯定都深有体会。以前遇到不懂的语法、想不通的需求,我们都是先翻个半小时 Google,然后在众多不靠谱的资料中找答案。现在,跟 ChatGPT 聊着聊着就把活干完了,写代码跟说话一样简单。更有专门优化过的 AI 代码辅助工具,像 GitHub Copilot,能够分析程序员编写的代码、注释和上下文信息,自动生成高质量代码。

文本总结。GPT 在文本总结方面也是一大利器,模型能够快速理解文章的主题和关键信息,提炼关键信息,然后生成简洁而准确的摘要。网上已经有很多相关的 AI 工具,比如 ChatPdf、ChatDoc,这些工具允许我们上传自己的文件后,可以对它提问任何关于这份上传文件的任何内容,AI 会帮我们进行总结和分析。

数据分析。利用 GPT 的自然语言处理能力,我们可以更方便地解读和理解数据,做出决策,提高整个数据分析流程的效率。比如,在分析多个复杂图表时,以往我们需要耗时很长才能发现数据的趋势和变化,GPT 可以一眼分析出图表之间的关联性,并输出一份简单易懂的解读报告,帮助我们挖掘出有用信息。

另外,将 GPT 与传统数据分析工具相结合,比如 GPT + SQL,数据分析人员不再需要写复杂难懂还容易出错的 sql 语句,只需要以自然语言形式提出问题,例如:“最近几个月哪个产品的销售额增长最快?” GPT 便能自动转成 sql 语句,去数据库中查询得到结果,再结合一些报表工具,还能一步到位画出图表。

大语言模型基本知识

我们已经了解了大语言模型的应用场景,在开始 AI 应用开发前,我们还需要学习一些大语言模型的基本知识。

LLM、GPT、ChatGPT 是什么关系?

首先,我们要理清 LLM、GPT、ChatGPT 这三者的区别和联系。

LLM,全称 Large Language Model,泛指大型语言模型,这其中不仅包括 GPT 和 ChatGPT,也包括其他大语言模型。我们本课程说的 AI 应用开发,也可以称 LLM 应用开发。

GPT,全称 Generative Pre-trained Transformer,由 OpenAI 开发的一系列模型,基于 Transformer 架构,通过预训练学习大规模数据,然后在特定任务上进行微调,可以适应各种自然语言处理任务。

ChatGPT 是 GPT 系列模型的一个特定应用,经过微调优化,使其更像人类,能与人类进行更有效的对话。

LLM的开发的方向选择

大语言模型(Large Language Model,LLM)就好比大脑,OpenAI、Google 这些大厂把这个大脑开发得越来越 “聪明”,但怎么用这个大脑,让它更好地落地到实际业务场景中,这就是 LLM 应用开发,也是我们小册的主要内容。

LLM 应用开发目前有两个比较热门的方向,一个是 RAG 应用开发,另外一个是 AI Agent 开发。

RAG 应用是结合大型语言模型(LLM)和外部知识检索的生成式 AI 应用设计模式。它通过检索获取相关的知识并将其融入 Prompt,让大模型能够参考相应的知识从而给出超出训练集以外的知识,同时也能有效消除大模型 “幻觉” 的问题。

AI Agent 充分利用 LLM 的推理决策能力,通过增加规划、记忆和工具调用的能力,构造一个能够独立思考、逐步完成给定目标的智能体。

最后修改:2024 年 07 月 26 日

© 允许规范转载