大模型时代,开源与闭源模型不断涌现,构成了大模型领域的双重引擎。开源大模型为AI领域注入了新的活力,基于开源大模型的应用如雨后春笋般出现,同时也为研究者和开发者提供了更广阔的创新空间。

在此,我们梳理了当前开源大模型的各个项目,让我们共同探寻这些令人振奋的进展。

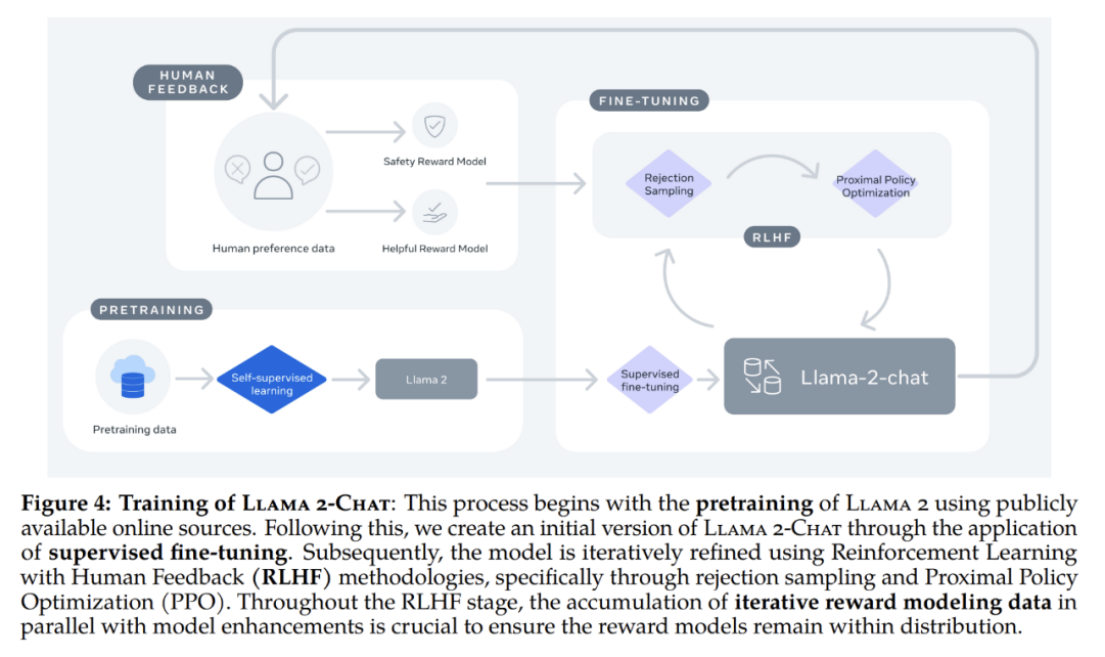

Llama 2

论文:Llama 2: Open Foundation and Fine-Tuned Chat Models

开源: https://github.com/meta-llama/llama

机构: Meta AI

Llama 2 是一系列预训练和微调的大型语言模型,参数规模从70亿到700亿不等。 其中,特别推出了经过优化用于对话场景的微调模型,称为Llama 2-Chat。

这些模型在测试的大多数基准测试中均胜过开源对话模型,在用户评估中获得了良好的帮助性和安全性评分,有可能成为封闭源模型的合适替代品。

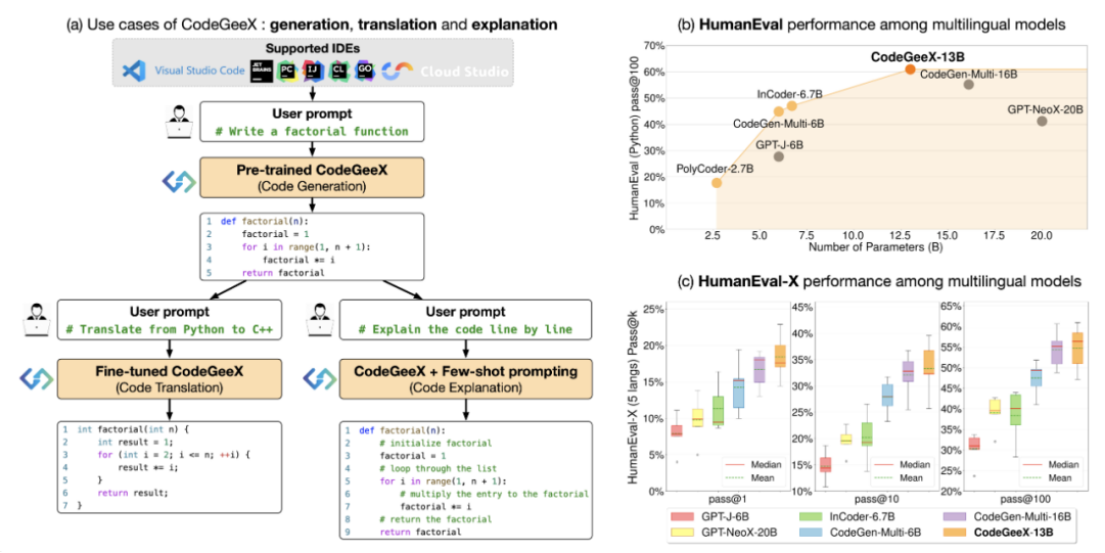

CodeGeeX

论文:CodeGeeX: A Pre-Trained Model for Code Generation with Multilingual Evaluations on HumanEval-X

开源: https://github.com/THUDM/CodeGeeX

机构: 清华大学、智谱AI、华为

CodeGeeX,是一个拥有130亿参数的多语言代码生成模型。 它的优势在于能够生成语法和功能正确的代码,极大地提高了程序员的编码效率,并使我们对人工智能的普适性更加接近。

CodeGeeX在2022年6月基于230亿token的23种编程语言进行了预训练。大量实验证明,CodeGeeX在HumanEval-X上的表现优于规模相似的多语言代码模型,无论是在代码生成还是翻译任务上。

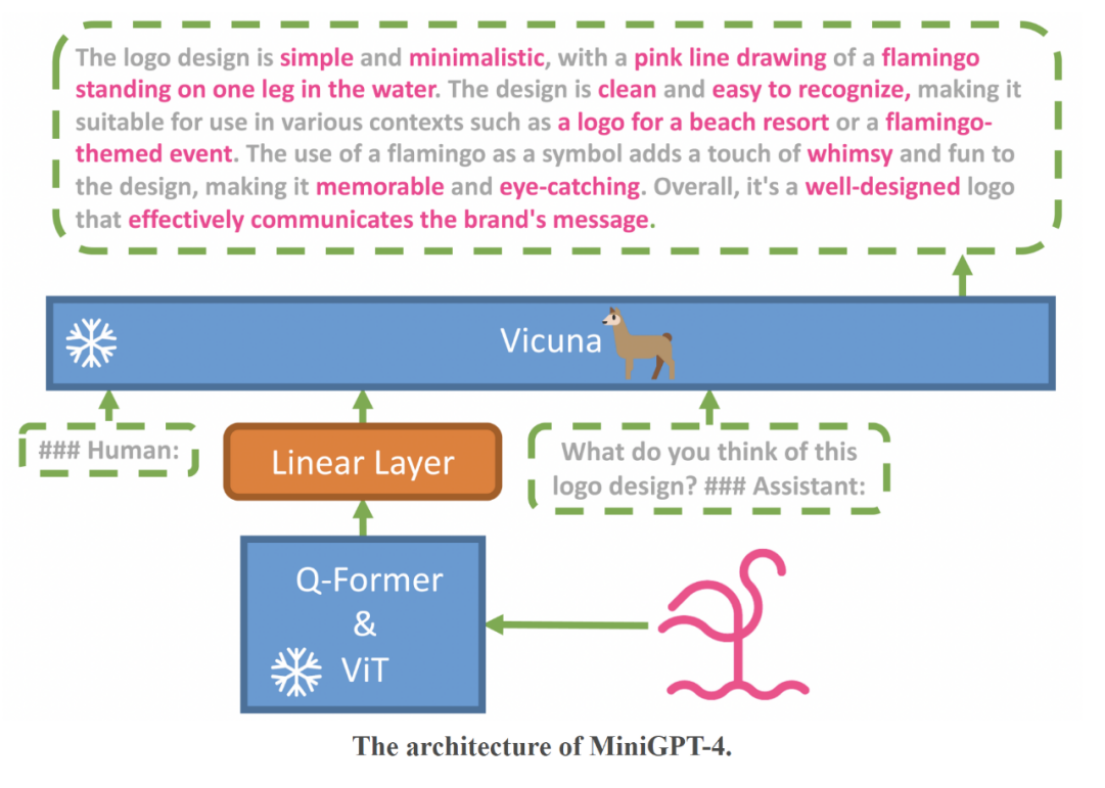

MiniGPT-4

论文:MiniGPT-4: Enhancing Vision-Language Understanding with Advanced Large Language Models

开源: https://minigpt-4.github.io/

机构: King Abdullah University of Science and Technology

MiniGPT-4结合了一个冻结的视觉编码器和一个冻结的大型语言模型Vicuna,仅使用一个投影层。 MiniGPT-4展现出类似于GPT-4的多种能力,比如生成详细的图像描述,从手写草稿创建网站等。

此外,MiniGPT-4还展示了其他新兴的能力,包括根据给定图像创作故事和诗歌,为图像中展示的问题提供解决方案,根据食物照片教用户如何烹饪等。

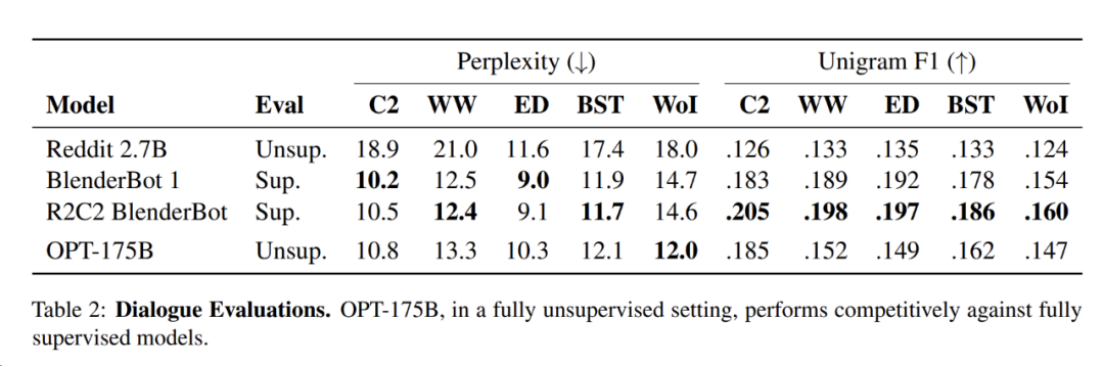

OPT

论文:OPT: Open Pre-trained Transformer Language Models

开源: https://github.com/facebookresearch/metaseq

机构: Meta AI

OPT是一系列仅包含解码器的预训练transformers模型,参数范围从125M到175B。 这些模型在零样本学习和少样本学习方面展现出卓越的能力。

与其他大型语言模型相比,OPT模型具有重要优势:首先,这些模型的训练成本较低,仅需1/7的碳足迹即可达到类似GPT-3的性能水平;其次,OPT模型的权重可完全和负责任地与感兴趣的研究人员共享,这为研究者提供了更多研究和实验的机会。

CPM

论文:CPM: A Large-scale Generative Chinese Pre-trained Language Model

开源: https://github.com/TsinghuaAI/CPM-1-Generate

机构: 清华大学

CPM是中文预训练语言模型。CPM由26亿参数和100GB中文训练数据组成,是目前为止最大的中文预训练语言模型之一。 它采用了大规模中文训练数据进行生成式预训练,旨在为多项下游中文自然语言处理任务提供支持。

相较于其他模型,CPM专注于中文训练数据,因此在处理中文自然语言处理任务时更为得心应手。

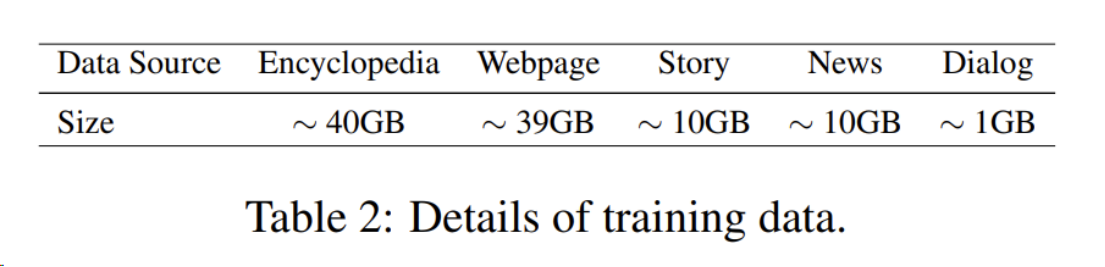

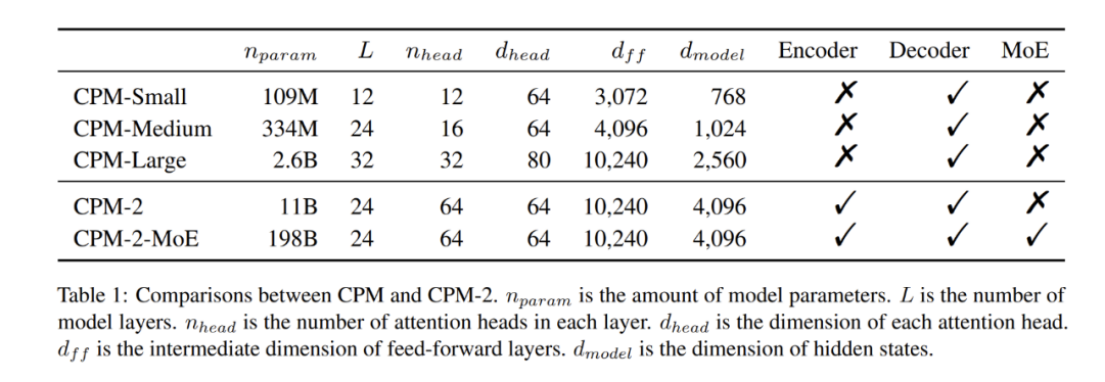

CPM-2

论文:CPM-2: Large-scale cost-effective pre-trained language models

开源: https://github.com/TsinghuaAI/CPM

机构: 清华大学

CPM-2是一个基于大规模预训练语言模型(PLMs)的成本效益技术套件。 它通过一系列技术来解决PLMs的效率问题,包括知识继承、提示微调和推理工具包infmoe。

首先,利用知识继承加速预训练过程,利用现有的PLMs而不是从头开始训练模型。其次,探索了大规模PLMs的提示微调最佳实践,显著减少了任务特定参数的数量。最后,实现了一个新的推理工具包infmoe,用于在有限的计算资源下使用大规模PLMs。

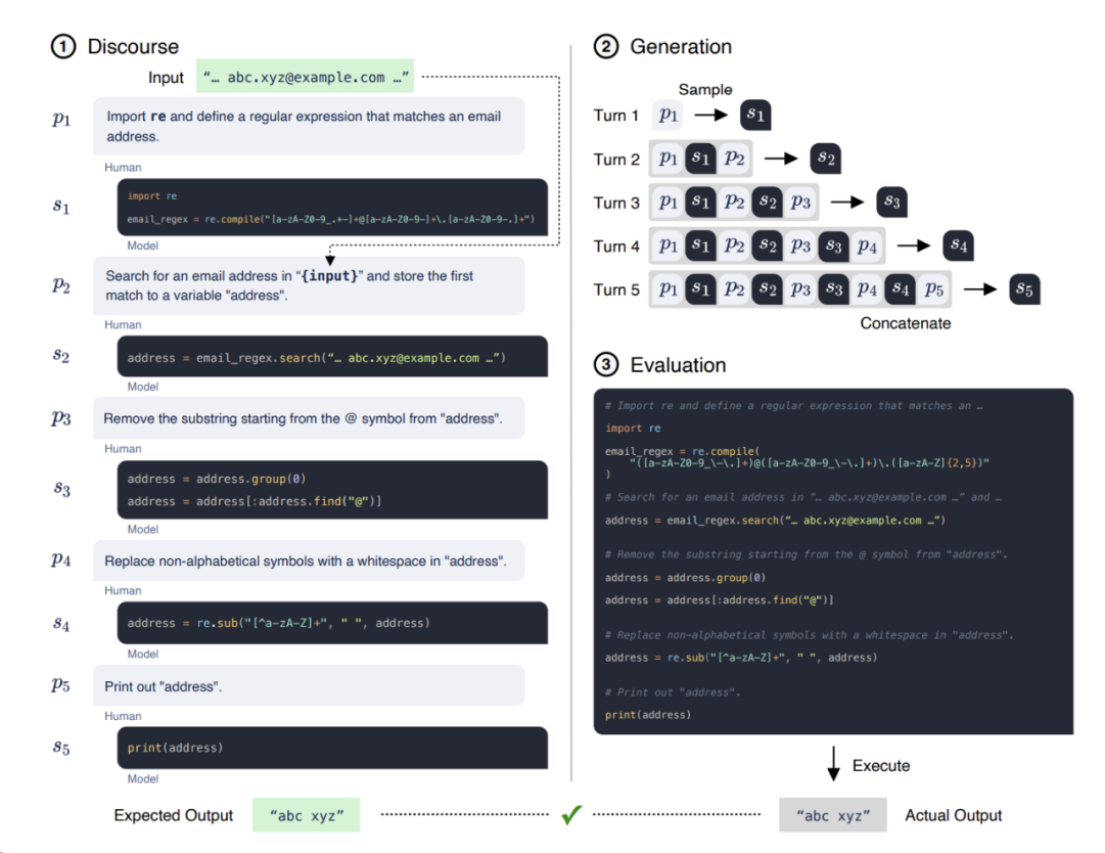

CodeGen

论文:CodeGen: An Open Large Language Model for Code with Multi-Turn Program Synthesis

代码: https://github.com/salesforce/CodeGen

机构: University of California & Salesforce

CodeGen是一个由自然语言和编程语言数据训练而成的大型语言模型系列,拥有高达16.1B个参数。 CodeGen的优势在于能够通过输入-输出示例或自然语言描述来生成计算机程序,这是程序合成的重要应用。

相较于先前的技术,CodeGen展示出在零样本Python代码生成上与现有最先进技术相媲美的实力,这归功于其在人类评估上的表现。

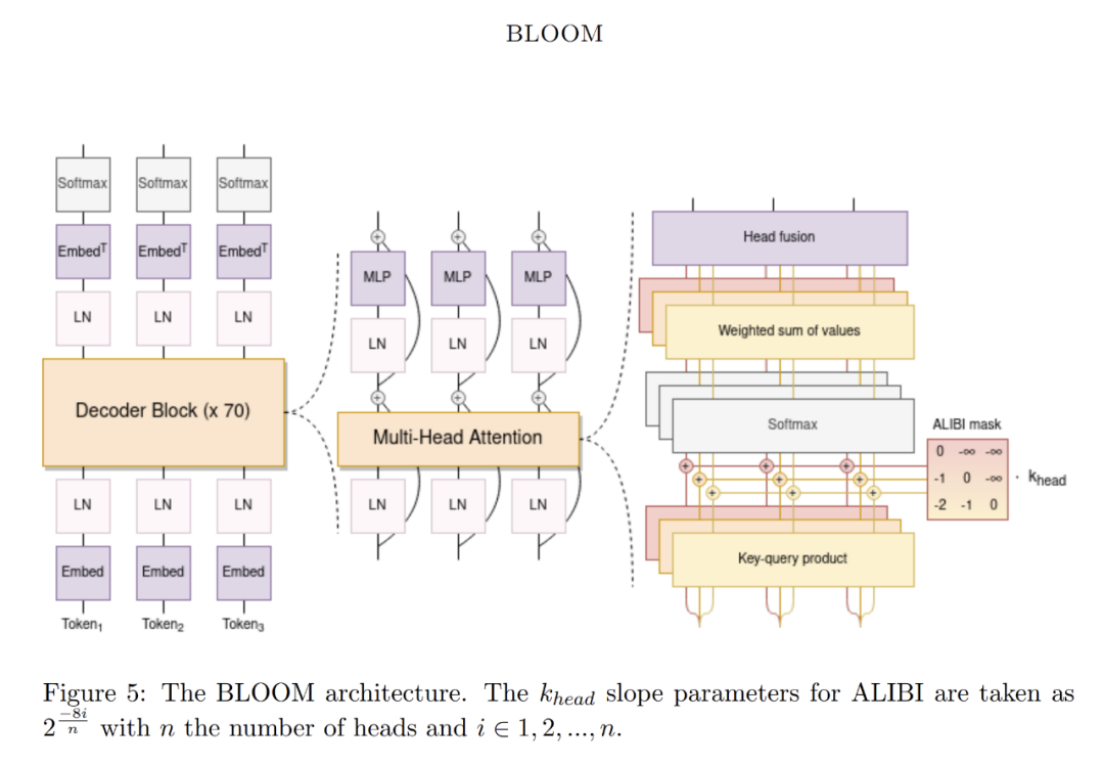

BLOOM

论文:BLOOM: A 176B-Parameter Open-Access Multilingual Language Model

开源: https://huggingface.co/bigscience/bloom

BLOOM是一个拥有1760亿参数的开放获取语言模型。 BLOOM由数百名研究人员合作设计和构建,是一个仅包含解码器的Transformer语言模型。

它在ROOTS语料库上进行训练,该语料库包含46种自然语言和13种编程语言的数百个来源(总共59种语言)。BLOOM在各种基准测试中表现出色,经过多任务提示微调后的结果更加强大。

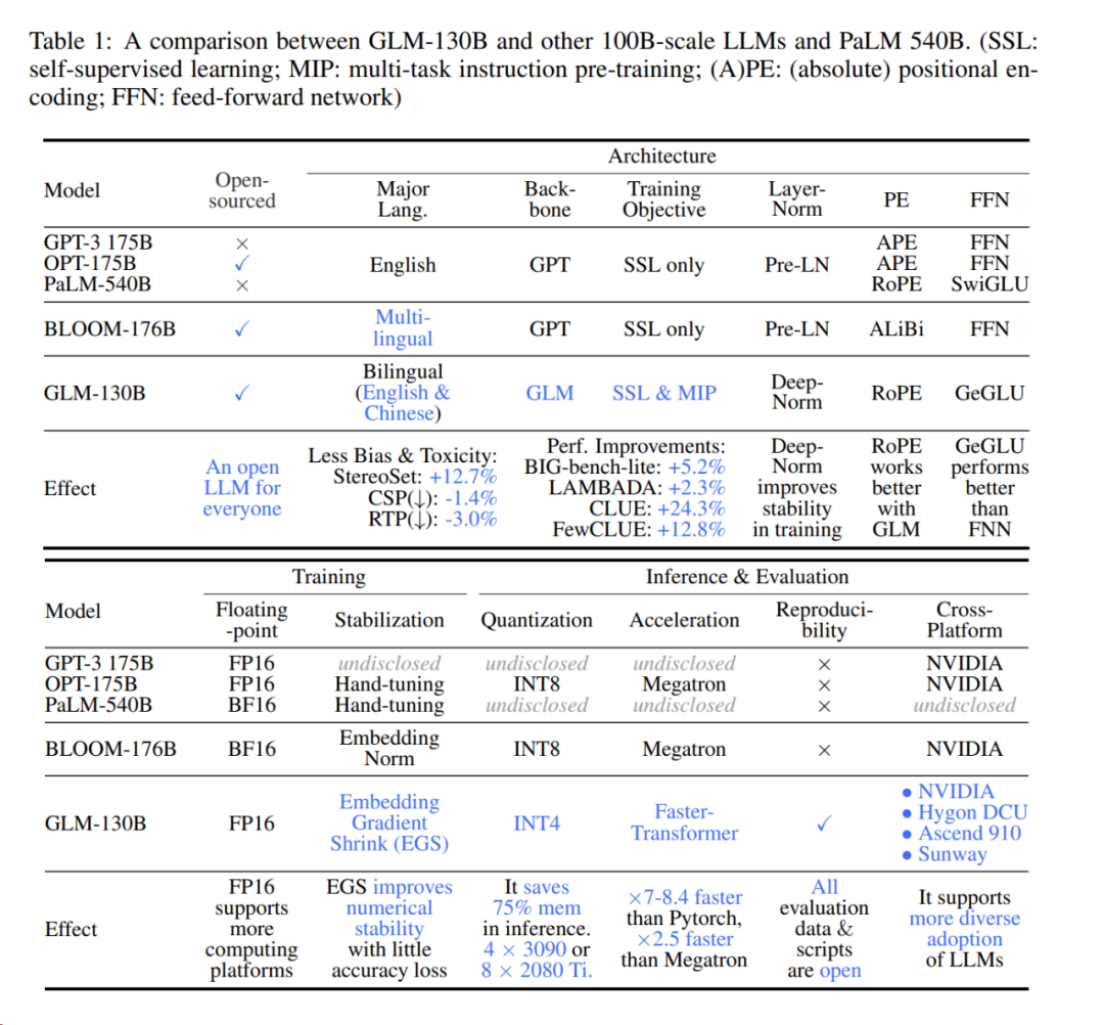

GLM-130B

论文:GLM-130B: An Open Bilingual Pre-trained Model

开源: https://github.com/THUDM/GLM-130B

机构: 清华大学

GLM-130B是一个拥有1300亿参数的双语(英文和中文)预训练语言模型。

该模型旨在开源一个至少与GPT-3一样出色的1000亿规模模型,并揭示这种规模的模型如何成功地进行预训练。

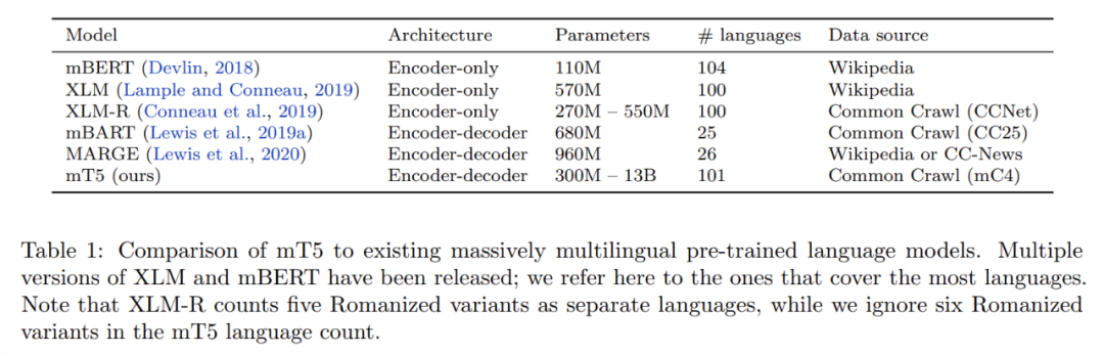

mT5

论文:mT5: A massively multilingual pre-trained text-to-text transformer

开源: http://goo.gle/mt5-code

机构: Google

mT5是T5的多语言变体, 采用了统一的text-text格式和大规模训练,通过在覆盖101种语言的新Common Crawl数据集上进行预训练。

mT5的设计和修改训练方法在论文中有详细描述,展示了在许多多语言基准任务上的最先进表现。

选择开源模型与商业模型的考量

在这篇文章中,我们介绍的所有语言模型都是开源的。实际上,选择开源或商业模型通常取决于具体需求和考量,但开源模型在以下方面可能更有优势:

• 更高的可控性:开源模型提供了高度的控制权,用户可以根据需要访问和微调模型,这种自定义和适应性是商业模型难以实现的。

• 数据安全:开源模型可以在本地或私有云基础设施内运行,提供更多的数据安全控制。使用商业模型可能存在数据隐私问题,因为数据通常需要发送到服务提供商的服务器上处理。

• 成本效益:使用开源模型可能更具成本效益,尤其是考虑到使用商业模型可能涉及的API调用或令牌费用。开源模型可以在无需这些持续成本的情况下部署,尽管可能需要对基础设施和维护进行投资。

• 社区和协作的优势:开源模型受益于社区的集体智慧,快速改进、BUG修复和新功能的引入往往是协作开发的结果。

• 避免供应商锁定:依赖开源模型可以消除对特定供应商的路线图、价格变化或服务可用性的依赖。

专门LLMs与通用模型的对比

专门的LLMs,如Code Llama,提供了在其专业领域内的集中性能提升,被设计为在特定任务中表现出色,为那些应用提供更准确、更相关的输出。

与此同时,通用模型如Llama 2被构建以处理广泛的任务。虽然它们可能无法与专门模型在任务特定的精确度上匹配,但其广泛的知识基础和适应性使它们成为多种应用的有用工具。

选择专门或通用LLMs取决于任务的具体需求。在高风险或小众任务中,专门模型更适合,因为精确度更重要;而通用模型提供了更好的灵活性和广泛的实用性。

大规模部署LLMs的伦理考虑

LLMs的伦理部署需要仔细考虑偏见、透明度、问责制以及潜在滥用等问题。确保LLMs不会延续其训练数据中存在的偏见是一个重要挑战,需要持续的警觉和训练方法的改进。在高风险应用中,透明公开LLMs的决策方式和训练数据对于建立信任和问责制至关重要。

生产中部署LLMs的策略

在生产中部署LLMs是一个复杂的过程,这里有一些策略可供考虑:

1. 选择合适的模型大小:平衡模型大小与应用的延迟和吞吐量需求非常重要。较小的模型可以提供更快的响应和降低计算成本,而较大的模型可能提供更准确和细致的输出。

2. 基础设施的考虑:确保您的基础设施能够处理计算负载。使用支持GPU的云服务或通过量化和修剪技术优化模型可以帮助管理资源需求。具有自动扩展功能的无服务器平台是没有基础设施专业知识的团队的好选择。

3. 计划可扩展性:您的部署策略应允许根据需求扩展或缩小。使用Docker等容器化技术和Kubernetes等编排技术可以支持可扩展的部署。

4. 建立健全的日志和可观察性:实施全面的日志和可观察性工具将有助于监控系统的健康状态并快速诊断问题。

5. 利用API实现模块化:API可以简化模型托管、扩展和管理的复杂性,同时方便与现有系统的集成,允许更容易的更新和维护。

6. 考虑模型服务框架:如BentoML、TensorFlow Serving、TorchServe或ONNX Runtime等框架可以简化部署,提供版本控制并处理请求批量以提高效率。